모두의 연구소 음성인식 풀잎스쿨에서 공부한 내용을 정리했습니다. 공부에 사용한 교재는 Speech and Language Processing 3rd Edition Appendix A: Hidden Markov Models, Speech and Language Processing 2nd Edition 9.1 ~ 9.2: The Hidden Markov Model Applied to Speech입니다.

Speech Recognition Architecture

Large-Vocabulary Continuous Speech Recognition(LVCSR) ; vocab이 크고 continuous한 발화를 기준으로 한다. 음성인식은 waveform을 input으로 받아 output으로 word sequence를 출력하는 task. 이를 Hidden Markov Model(HMM) 기반의 방법론으로 모델링한다. 이 방법론의 목표는 다음과 같다.

"What is the most likely sentence out of all sentences in the language L given some acoustic input O?"

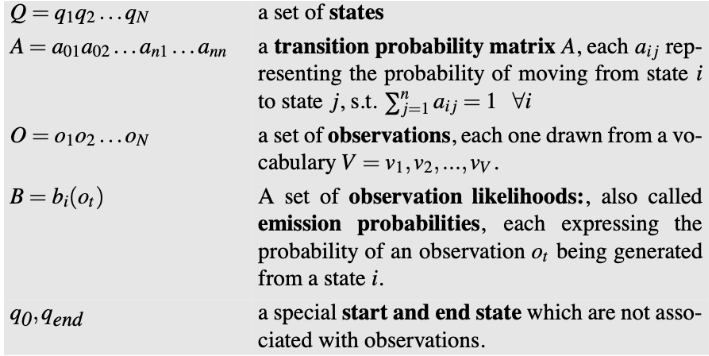

HMM-based speech recognition에서 쓰이는 개념에 대해 알아보자.

Acoustic sequence(observation)

$O = o_1, o_2, o_3, ... , o_n$

관측값, 즉 발화에서 feature extraction한 MFCC. O의 길이는 가변적이라 알 수 없다. 또한 waveform이기 때문에 unalined learning이다. (한편, NLP에서는 supervised learing으로 HMM 모델링을 한다.)

예를 들어 "모두~연" vs. "모~두연" 같이 특정 음소의 길이를 정할 수 없어, 특정 음소가 몇 번째 sequence까지 해당될지 알 수 없다.

Sentence(a string of words)

$W = w_1, w_2, w_3, ... , w_n$

Model

음성인식의 모델은 AM, LM 크게 두 가지로 구성된다.

$\widehat{W} = argmax_{w\in L} P(W|O)$

인풋 acoustic sequence가 들어갔을 때 Sentence의 조건부 확률

$\widehat{W} = argmax_{w\in L} P(O|W)P(W)$

P(W|O)를 argmax하는 task를 베이즈룰을 활용해서 P(O|W)P(W)를 argmax하는 task로 바꿔준다. 여기서 P(O|W)가 acousitc model(AM)이고 P(W)가 language model(LM)이다. LM은 베이지안 estimator 관점에서 prior 분포에 해당한다. 다음과 같이 N-gram으로 모델링한다.

AM은 베이지안 estimator 관점에서 관측값의 가능도(observation likelihood)가 되고 HMM-GMM으로 모델링한다. HMM lexicon은 word에 대응(mapping)하는 phone sequence(사전)를 가지고 있다. lexicon에 없는 phone은 b2p 등을 이용한다. 그래서 HMM은 phones sequence가 주어졌을 때의 특정 word가 관측될 확률을 계산한다. GMM은 특정 phones에서 특정 acoustic feature가 관측될 확률을 계산한다.

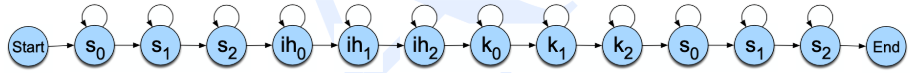

위 그림을 보면 six라는 단어에 대한 HMM이다. 각 HMM state는 phone을 가지고 있고 이 전체 state는 six라는 word를 의미한다. 또한 각 state의 phone이 주어졌을 때 특정 acousitc feature가 관측될 확률을 GMM으로 계산(모델링)한다.

정리하면 각각의 word(pronunciations)는 하나의 HMM 모델로 구성되고 HMM 모델은 phones, sub-phones을 state 값으로 가진다. 이 각 state의 phone에 대응하는 acoutic feature가 관측될 확률을 GMM으로 계산한다. 이 AM(acousitc model)을 더 자세히 알아보자.

Hidden markov model(HMM)

Hidden markov model based speech recognition

1. single phone이 HMM 각각 하나의 hidden state에 대응되는 경우

HMM은 left to right (basic network, right to left는 silence 처리 task에 사용) 모델이다. Phone은 사람의 발성에 의존하기에 사람에 따라 같은 phone이라도 발화되는 time range가 달라지는 문제가 생겨 다음과 같은 모델을 고려한다.

2. single phone 하나를 3개의 hidden state에 mapping(subphone model)

Spectral feature가 stationary 하지 않을 수 있으므로 하나의 phone을 세 개로(0,1,2) 나누는 아이디어. 각 state가 subphones이 되고 각 state마다 distribution을 가진다. 위와 동일하게 left-to-right model이다. 하나의 subphone도 서로 연관이 있으므로 후에 tria-phone이라는 발전된 모델이 나오게 된다.

[음성인식] 4.2 Hidden Markov Model로 이어집니다.

reference

'Audio & Speech' 카테고리의 다른 글

| 음성 데이터의 활용 (0) | 2020.02.17 |

|---|---|

| [음성인식] 5.1 Vector Quantization(VQ) (0) | 2020.02.15 |

| [음성인식] Lec.3 Acoustic feature extraction (0) | 2020.02.01 |

| [음성인식] Lec.2 Phonetics & Signal process 기본 개념 (0) | 2020.01.17 |

| [음성인식] Lec.1 OT - 음성인식 개론 (0) | 2020.01.11 |